币圈子(120btc.CoM):人工智能AI的电力消耗正惊人速度增长,预计最快在2025年底前便可能超越比特币挖矿的耗电量,并超过全球资料中心近一半的总耗电量。这项严峻的警讯,来自荷兰阿姆斯特丹自由大学环境研究所Alexde Vries-Gao博士近期发表于《Joule》期刊的最新研究《Artificial intelligence: Supply chain constraints and energy implications》。

AI耗能远超预期

研究数据指出,仅在2023年至2024年间,NVIDIA与AMD生产的AI加速器模组,其累积热设计功耗(TDP)总计已高达3.8百万瓩(GW),此数据相当于爱尔兰全国一整年的电力消耗。

若将所有采用台积电先进封装技术(CoWoS)的AI硬件纳入考量,例如Google的TPU,并计入散热等辅助设备构成的整个AI系统总耗电,目前全球已部署的AI系统电力需求,据估计已达到5.3至9.4GW的惊人规模。

Alexde Vries-Gao博士在研究中进一步预测:「如果台积电如期在2025年将CoWoS产能再次倍增,到今年底,累计生产的AI系统电力需求可能达到23GW。这不仅将超越比特币挖矿的耗电量,更将接近2024年非加密货币资料中心总耗电量的一半。」

此番言论凸显了AI发展对全球电力供应的潜在压力。事实上,台积电的CoWoS封装技术产能,已被广泛视为AI加速器制造流程中的主要瓶颈。

研究内统计,台积电的CoWoS产能从2023年的约12.65万片(300mm晶圆)增长至2024年的约32.74万片,增幅超过一倍。

市场分析师估计,NVIDIA和AMD合计占用了台积电CoWoS产能的52%(2023年)和58%(2024年),其中,NVIDIA的单独占比更是分别达到44%(2023年)和48%(2024年),显示其在AI硬件市场的庞大需求。

能源效率的拉锯战

AI能源需求为何飙升,主要是因为产业普遍抱持「更大规模的模型表现更佳」的观念,这直接导致AI模型的规模与复杂度不断攀升,耗能也跟着提升。

虽然部分模型效率有所改进,例如中国DeepSeek R1模型宣称能减少对高阶硬件的依赖,但模型规模的持续扩大,往往轻易抵销了这些效率上的增益,甚至可能产生所谓的「回弹效应」,使得总体能耗不减反增。

与此同时,科技巨头对于AI能耗数据普遍维持低透明度,以Google为例,该公司曾在2019至2021年间提供相关数据,显示机器学习当时约占其总能源使用的10%至15%。随后便停止披露此类数据,并声称区分AI与其他工作负载的能耗「没有意义」。

虽然欧盟AI法案要求披露通用AI模型训练阶段的能耗,但对于占据更大耗电比例的推论(Inference)阶段,却并无强制要求,且相关规定最快也要到2025年8月才会正式生效。

Alexde Vries-Gao强调:「缺乏透明度是我们面临的最大挑战之一。没有准确数据,政策制定者和研究人员就无法全面评估AI的环境影响并制定有效的监管框架。」

电网压力与环境隐忧

这种能源需求的快速增长,正对每个先进国家的电网构成严重挑战。资料中心的建设速度(通常仅需1至2年)远快于电网的规划与建设周期(往往需要5至10年),这种时间差导致了所谓的「电力容量危机」。

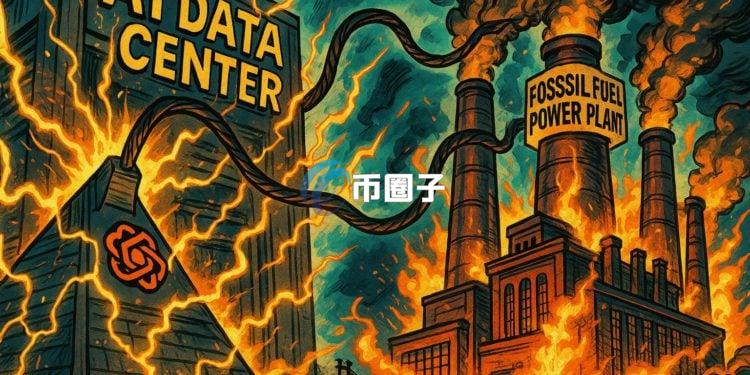

更令环保人士担忧的是,新建AI资料中心可能进一步加深对化石燃料的依赖,例如OpenAI/Stargate和Crusoe能源公司先前的合作计划,将为资料中心提供高达4.5GW的天然气发电容量。

美国是全球最大的资料中心电力消耗国,占全球总量的约45%,其次是中国(25%)和欧洲(15%)。目前美国对于AI冲刺的目标,似乎将电力消耗带来的隐忧暂时放下;而中国电力等相关AI资料,则更不清晰。

评论(0)